Imaging of Matter

Mikroskopie: Forschende fordern mehr Bewusstsein für KI-Herausforderungen

3. Oktober 2025

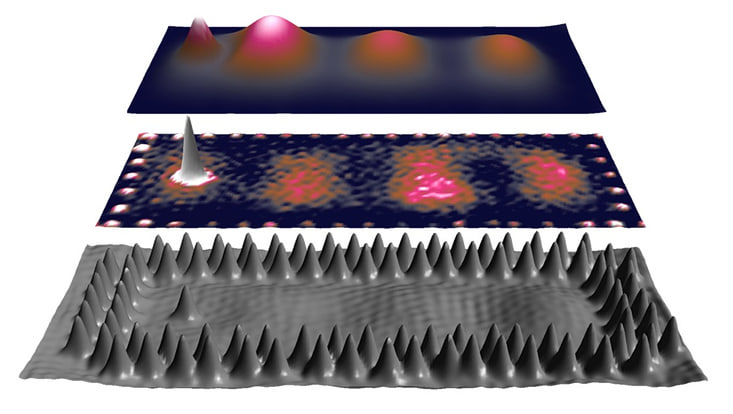

Foto: Nature, reprint with permission

Generative Künstliche Intelligenz (KI) hat in den letzten Jahren erhebliche Fortschritte gemacht. Selbst hochkomplexe Mikroskopbilder können heute mit einfachen Mitteln gefälscht werden, sodass auch Fachleute zwischen echten und manipulierten Bildern kaum noch unterscheiden können. In einer kürzlich in Nature Nanotechnology erschienenen Publikation diskutiert ein internationales Team von Nanowissenschaftlerinnen und -wissenschaftlern Strategien zur Wahrung der Integrität ihres Fachgebiets.

Die Nanomaterialwissenschaft nutzt mikroskopische Methoden, um entscheidende Eigenschaften wie Gleichmäßigkeit, Größe, Form, Kristallinität, Zusammensetzung und Festigkeit eines Materials zu bestimmen. Diese Kenntnisse sind essenziell für zahlreiche Anwendungen – beispielsweise in der Energie, Katalyse und Nanomedizin. Bereits seit längerem beobachten Forschende Fälle wissenschaftlichen Fehlverhaltens, bei denen durch Manipulation der Mikroskopiebilder ein falscher Eindruck von der Probenqualität vermittelt wurde. „Dieses Problem hat sich in letzter Zeit verschärft, da generative künstliche Intelligenz mittlerweile in der Lage ist, maßgeschneiderte gefälschte Derivate jeder bildbasierten Technik zu erstellen“, erklärt Wolfgang Parak, Professor am Institut für Nanostruktur- und Festkörperphysik der Universität Hamburg und Forscher im Exzellenzcluster „CUI: Advanced Imaging of Matter“. Er und seine Co-Autorinnen und -Autoren halten es für dringend notwendig, das Problem anzuerkennen und mögliche Lösungen zu diskutieren.

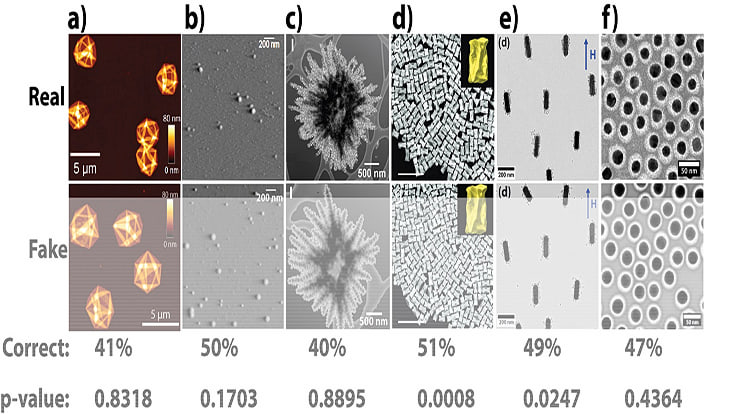

Um die Problematik zu verdeutlichen, führte das Team eine anonyme Umfrage unter Wissenschaftlerinnen und Wissenschaftlern durch. Dabei wurden den Teilnehmenden entweder echte Mikroskopbilder oder von KI generierte Versionen gezeigt. Die 250 Teilnehmenden waren aufgefordert, zu beurteilen, ob die Bilder „echt“, „gefälscht“ oder „unsicher“ seien. Das Ergebnis: Die Mehrheit konnte kaum zwischen echten und gefälschten Nanomaterialbildern unterscheiden.

Vielfältige Konsequenzen für die Forschung

Diese Erkenntnis hat vielfältige Konsequenzen: Beispielsweise werden herkömmliche Verfahren zur Aufdeckung wissenschaftlichen Fehlverhaltens obsolet. Die Wissenschaftlerinnen und Wissenschaftler fordern daher, bewährte Methoden gegen Bildmanipulation zu stärken. So empfehlen sie, Rohdatendateien gemeinsam mit Veröffentlichungen zugänglich zu machen, da es für KI-Systeme wesentlich schwerer ist, mit solchen Dateien zu manipulieren. Da Rohdatendateien oft nur mit spezieller, gerätespezifischer Software zugänglich sind, sollte eine universelle Software entwickelt werden, die alle Formate öffnen kann.

Ein weiterer wichtiger Schritt wäre die Nutzung von KI zur automatischen Erkennung gefälschter Bilder – eine Idee, die innerhalb der wissenschaftlichen Gemeinschaft bereits an Bedeutung gewinnt. In Bezug auf Mikroskopiebilder von Nanomaterialien plädieren die Forschenden für einen Perspektivwechsel: Unvollkommenheiten sollten akzeptiert werden, denn nicht alle Nanomaterialien oder -zusammensetzungen sind perfekt. Zudem ist es entscheidend, deutlich zu kennzeichnen, ob Bilder für soziale Medien geschönt wurden.

Abschließend regen die Wissenschaftlerinnen und Wissenschaftler an, Replikationsstudien zu häufig zitierten Publikationen durchzuführen, in denen neue Materialien vorgestellt werden. Parak betont: „Es ist wichtig, dass sich unsere Gemeinschaft mit dem unethischen Einsatz von KI auseinandersetzt und ihn als wachsendes Problem anerkennt.“

Originalpublikation

Nadiia Davydiuk, Elisha Krieg, Jens Gaitzsch, Patrick M. McCall, Günter K. Auernhammer, Mu Yang, Joseph B. Tracy, Sara Bals, Wolfgang J. Parak, Nicholas A. Kotov, Luis M. Liz-Marzán, Andreas Fery, Matthew Faria & Quinn A. Besford

The rising danger of AI-generated images in nanomaterials science and what we can do about it

Nature Nanotechnology 20, 1174-1177